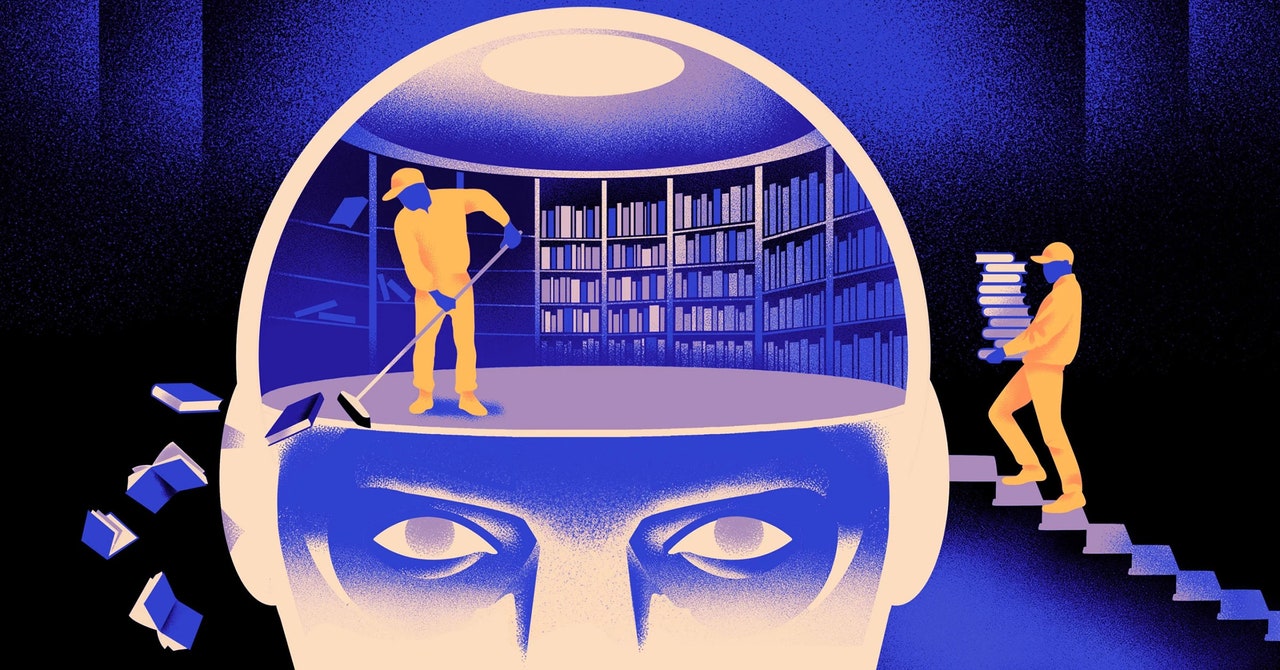

Selective Forgetting Can Help AI Learn Better

La version originale de cette histoire est apparu dans Combien de magazine.

Une équipe d'informaticiens a créé un agile, plus flexible du modèle d'apprentissage automatique. L'astuce: il doit oublier périodiquement ce qu'il sait. Et bien que cette nouvelle approche ne déplace pas les énormes modèles qui sous-tendent les plus grandes applications, il pourrait en révéler plus sur la façon dont ces programmes comprennent la langue.

La nouvelle recherche marque «une avance importante dans le domaine», a déclaré Attaques de jearingénieur de l'IA à l'Institut de sciences fondamentales en Corée du Sud.

Les moteurs linguistiques de l'IA utilisés aujourd'hui sont principalement alimentés par réseaux de neurones artificiels. Chaque «neurone» du réseau est une fonction mathématique qui reçoit des signaux d'autres neurones de ce type, exécute certains calculs et envoie des signaux à travers plusieurs couches de neurones. Initialement, le flux d'informations est plus ou moins aléatoire, mais grâce à la formation, le flux d'informations entre les neurones s'améliore à mesure que le réseau s'adapte aux données de formation. Si un chercheur d'IA souhaite créer un modèle bilingue, par exemple, elle entraînerait le modèle avec un gros tas de texte des deux langues, ce qui ajusterait les connexions entre les neurones de manière à relier le texte en une seule langue avec un équivalent mots dans l'autre.

Mais ce processus de formation prend beaucoup de puissance informatique. Si le modèle ne fonctionne pas très bien, ou si les besoins de l'utilisateur changent plus tard, il est difficile de l'adapter. “Disons que vous avez un modèle qui a 100 langues, mais imaginez qu'une langue que vous voulez n'est pas couverte”, a déclaré Mikel Artetxeco-auteur de la nouvelle recherche et fondatrice de la startup AI Reka. “Vous pouvez recommencer à zéro, mais ce n'est pas idéal.”

Artetxe et ses collègues ont tenté de contourner ces limites. Il y a quelques annéesArtetxe et d'autres ont formé un réseau de neurones dans une langue, puis ont effacé ce qu'il savait des éléments constitutifs des mots, appelés jetons. Ceux-ci sont stockés dans la première couche du réseau neuronal, appelé la couche d'intégration. Ils ont laissé toutes les autres couches du modèle seul. Après avoir effacé les jetons de la première langue, ils ont recyclé le modèle sur la deuxième langue, qui a rempli la couche d'intégration de nouveaux jetons de cette langue.

Même si le modèle contenait des informations incompatibles, le recyclage a fonctionné: le modèle pourrait apprendre et traiter la nouvelle langue. Les chercheurs ont supposé que si la couche d'intégration a stocké des informations spécifiques aux mots utilisés dans la langue, les niveaux plus profonds du réseau stockaient des informations plus abstraites sur les concepts derrière les langues humaines, ce qui a ensuite aidé le modèle à apprendre la deuxième langue.

«Nous vivons dans le même monde. Nous conceptualisons les mêmes choses avec des mots différents »dans différentes langues, dit Yihong Chenl'auteur principal du journal récent. «C'est pourquoi vous avez ce même raisonnement de haut niveau dans le modèle. Une pomme est quelque chose de sucré et de juteux, au lieu d'un simple mot. »