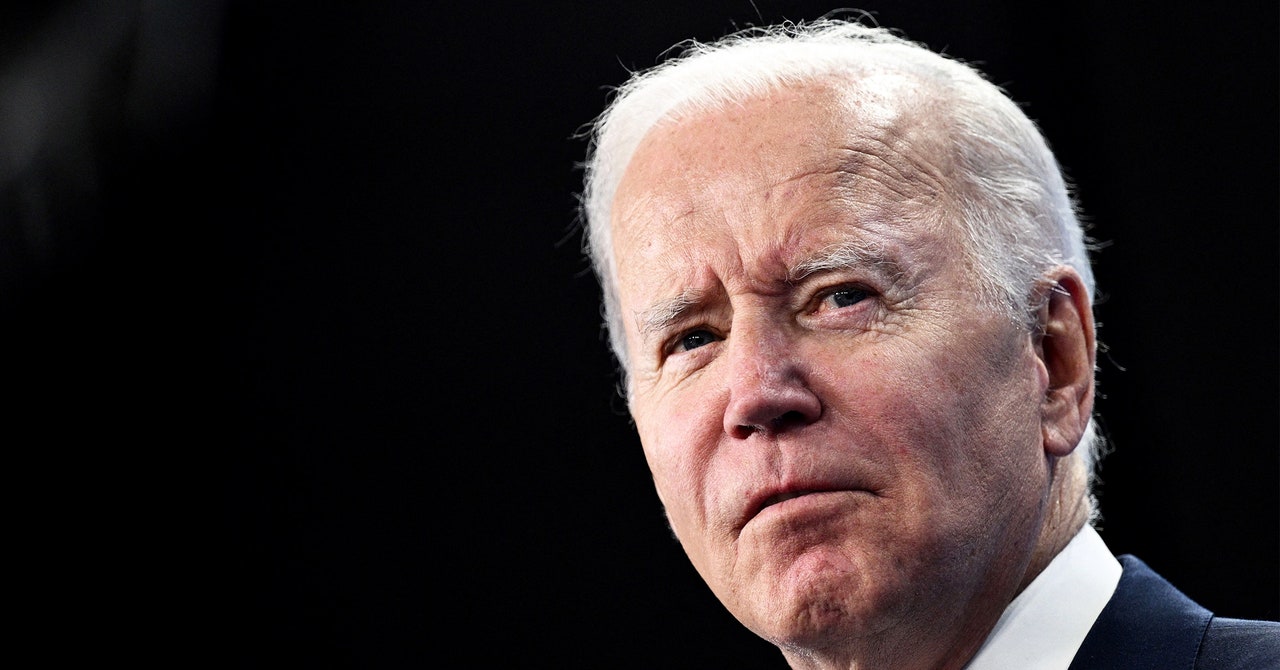

Joe Biden Wants US Government Algorithms Tested for Potential Harm Against Citizens

Le décret exécutif de l'IA de Biden exige que la CAMB fournisse ses conseils aux agences fédérales au cours des cinq prochains mois. Le bureau invite commentaire du public sur le projet de politique jusqu'au 5 décembre.

«Le cadre permet à un ensemble d'exigences contraignantes pour les agences fédérales de mettre en place des garanties pour l'utilisation de l'IA afin que nous puissions exploiter les avantages et permettre au public de faire confiance aux services fournis par le gouvernement fédéral», explique Jason Miller, directeur adjoint de l'OMB pour la gestion.

Le projet de mémo met en évidence certaines utilisations de l'IA où la technologie peut nuire aux droits ou à la sécurité, y compris les soins de santé, le logement et les forces de l'ordre – toutes les situations où les algorithmes ont entraîné une discrimination ou un refus des services.

Des exemples de risques de sécurité potentiels mentionnés dans le projet de l'OMB comprennent l'automatisation des infrastructures critiques comme les barrages et les véhicules autonomes comme la Cruise Robotaxis qui a été fermée la semaine dernière en Californie et fait l'objet d'une enquête par des régulateurs fédéraux et étatiques après qu'un piéton a heurté par un véhicule a été traîné à 20 pieds. Des exemples de la façon dont l'IA pourrait violer les droits des citoyens dans le projet de mémo incluent la police prédictive, l'IA qui peut bloquer la parole protégée, les logiciels de détection de plagiat ou d'émotion, les algorithmes de dépistage des locataires et les systèmes qui peuvent avoir un impact sur l'immigration ou la garde des enfants.

Selon l'OMB, les agences fédérales utilisent actuellement plus de 700 algorithmes, bien que les stocks fournis par les agences fédérales soient incomplètes. Miller dit que le projet de mémo oblige les agences fédérales à partager davantage sur les algorithmes qu'ils utilisent. «Notre attente est que dans les semaines et les mois à venir, nous allons améliorer les capacités des agences pour identifier et faire rapport sur leurs cas d'utilisation», dit-il.

La vice-présidente Kamala Harris a mentionné la note de l'OMB aux côtés d'autres initiatives responsables de l'IA dans les remarques aujourd'hui à l'ambassade des États-Unis à Londres, un voyage fait pour le Sommet britannique de la sécurité de l'IA cette semaine. Elle a dit que, bien que certaines voix dans l'IA de l'élaboration des politiques se concentrent sur des risques catastrophiques comme le rôle que l'IA peut jouer un jour dans les cyberattaques ou la création d'armes biologiques, de biais et de désinformation est déjà amplifiée par l'IA et affectant quotidiennement les individus et les communautés.

Merve Hickok, auteur d'un prochain livre sur la politique d'approvisionnement en IA et président du Centre à but non lucratif pour l'IA et la politique numérique, accueille la façon dont la note de l'OMB obligerait les agences à justifier leur utilisation de l'IA et à attribuer une responsabilité spécifique des personnes pour la technologie. C'est un moyen potentiellement efficace de s'assurer que l'IA ne se fait pas marteler dans tous les programmes gouvernementaux, explique Hickok, qui est également chargé de cours à l'Université du Michigan.

Mais la fourniture de dérogations pourrait saper ces mécanismes, craint-elle. «Je serais inquiet si nous commençons à voir les agences utiliser cette renonciation, en particulier les forces de l'ordre, la sécurité intérieure et la surveillance», dit-elle. “Une fois qu'ils ont obtenu la renonciation, cela peut être indéfini.”