ChatGPT’s Hunger for Energy Could Trigger a GPU Revolution

Le coût de Faire des progrès supplémentaires dans l'intelligence artificielle devient aussi surprenant qu'une hallucination par Chatgpt. La demande pour les puces graphiques appelées GPU nécessaires à la formation d'IA à grande échelle a entraîné des prix des composants cruciaux à travers le toit. Openai a déclaré que la formation de l'algorithme qui alimente désormais Chatgpt a coûté à l'entreprise plus de 100 millions de dollars. La race pour participer à l'IA signifie également que les centres de données consomment désormais de préoccupation quantités d'énergie.

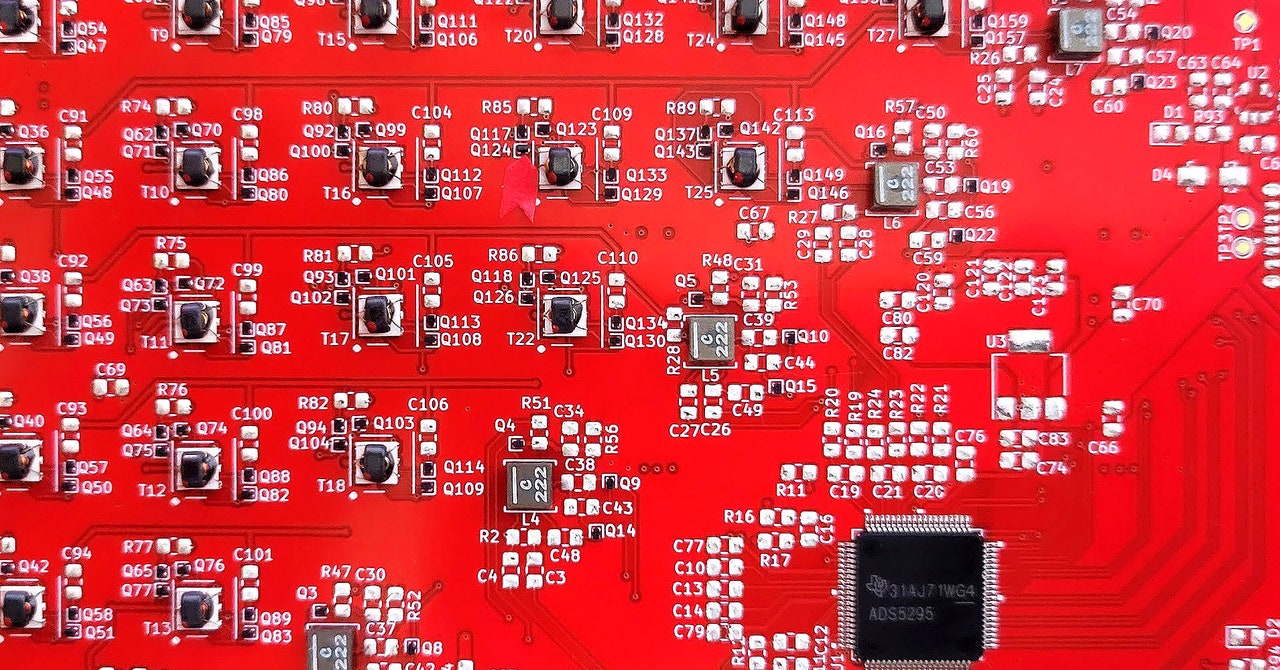

L'IA Gold Rush a quelques startups qui ont élaboré des plans audacieux pour créer de nouvelles pelles de calcul à vendre. Les GPU de NVIDIA sont de loin le matériel le plus populaire pour le développement de l'IA, mais ces arrivants soutiennent qu'il est temps de repenser radical la façon dont les puces informatiques sont conçues.

Informatique normaleune startup fondée par les vétérans de Google Brain et Alphabet's Moonshot Lab X, a développé un prototype simple Il s'agit d'une première étape vers le redémarrage de l'informatique à partir des premiers principes.

Une puce de silicium conventionnelle exécute des calculs en manipulant des bits binaires – les 0 et 1 – représentant des informations. L'unité de traitement stochastique de l'informatique normale, ou SPU, exploite les propriétés thermodynamiques des oscillateurs électriques pour effectuer des calculs en utilisant des fluctuations aléatoires qui se produisent à l'intérieur des circuits. Cela peut générer des échantillons aléatoires utiles pour les calculs ou pour résoudre les calculs d'algèbre linéaires, qui sont omniprésents dans la science, l'ingénierie et l'apprentissage automatique.

Faris Sbahi, le PDG de l'informatique normale, explique que le matériel est à la fois très efficace et bien adapté pour gérer les calculs statistiques. Cela pourrait un jour le rendre utile pour construire des algorithmes d'IA qui peuvent gérer l'incertitude, ce qui concerne peut-être la tendance des modèles de gros langage à «halluciner» les sorties lorsqu'elles sont incertaines.

Sbahi affirme que le récent succès de l'IA générative est impressionnant, mais loin de la forme finale de la technologie. «Il est clair qu'il y a quelque chose de mieux en termes d'architectures logicielles et de matériel», explique Sbahi. Lui et ses cofondateurs ont déjà travaillé sur l'informatique quantique et l'IA à Alphabet. Un manque de progrès dans l'exploitation des ordinateurs quantiques pour l'apprentissage automatique les a poussés à réfléchir à d'autres façons d'exploiter la physique pour alimenter les calculs requis pour l'IA.

Une autre équipe d'anciens chercheurs du quantum d'Alphabet a laissé Extroopiqueune entreprise toujours en furtivité qui semble avoir un plan encore plus ambitieux d'utilisation de l'informatique thermodynamique pour l'IA. «Nous essayons de faire tout l'informatique neuronale étroitement intégrée dans une puce thermodynamique analogique», explique Guillaume Verdon, fondateur et PDG d'Extropic. «Nous prenons nos apprentissages à partir de logiciels et de matériel informatiques quantiques et de le ramener au paradigme thermodynamique complet.» (Verdon a récemment été révélé comme la personne derrière le compte MEME populaire sur x Beff jezosassocié au soi-disant Mouvement accéléré efficace qui favorise l'idée d'un progrès vers une «singularité technocapitale».)

L'idée qu'une repensage plus large de l'informatique est nécessaire peut prendre de l'ampleur à mesure que l'industrie se heurte à la difficulté de maintenir la loi de Moore, la prédiction de longue date selon laquelle la densité des composants sur les copeaux se poursuit. «Même si la loi de Moore ne ralentit pas, vous avez toujours un problème massif, car les tailles de modèle qu'Openai et d'autres publient se développent bien plus rapidement que la capacité des puces», explique Peter McMahon, professeur à l'Université Cornell qui travaille sur de nouvelles façons informatiques. En d'autres termes, nous pourrions bien devoir exploiter de nouvelles façons de calculer pour garder le train de battage médiatique AI sur la bonne voie.