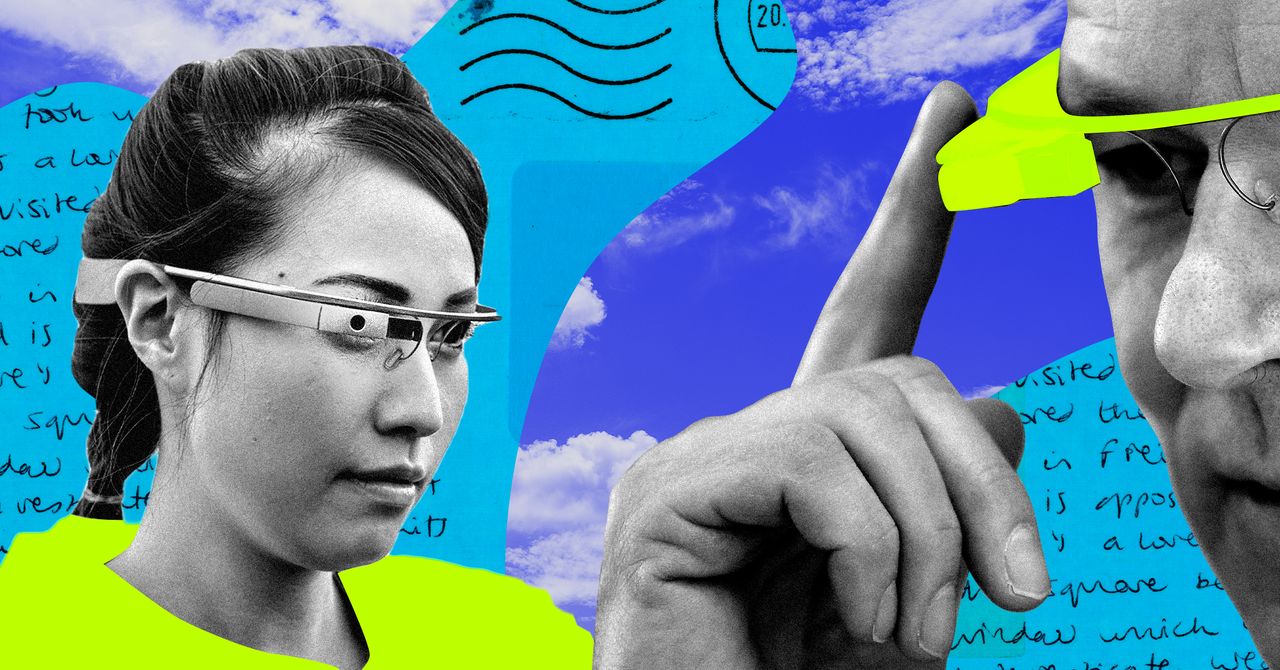

AI Could Change How Blind People See the World

L'intégration de l'IA dans la recherche de produits pour les yeux pourrait avoir un impact profond sur les utilisateurs, explique Sina Bahram, un informaticien aveugle et responsable d'un conseil qui conseille les musées, les parcs à thème et les sociétés technologiques comme Google et Microsoft sur l'accessibilité et l'inclusion.

Bahram a utilisé Be Eyes With GPT-4 et dit que le modèle grand langage fait une différence «ordres de grandeur» par rapport aux générations de technologie précédentes en raison de ses capacités, et parce que les produits peuvent être utilisés sans effort et ne nécessitent pas de compétences techniques. Il y a deux semaines, dit-il, il marchait dans la rue à New York lorsque son partenaire commercial s'est arrêté pour examiner de plus près quelque chose. Bahram a utilisé mes yeux avec GPT-4 pour apprendre qu'il s'agissait d'une collection d'autocollants, d'une caricaturale, plus du texte, des graffitis. Ce niveau d'information est «quelque chose qui n'existait pas il y a un an en dehors du laboratoire», dit-il. “Ce n'était tout simplement pas possible.”

Danna Gurari, professeure adjointe d'informatique à l'Université du Colorado à Boulder, dit qu'il est excitant que les aveugles soient sur le bord saignant de l'adoption de la technologie plutôt qu'une réflexion après coup, mais il est également un peu effrayant qu'une population aussi vulnérable ait à faire face au désordre et à l'incompilation de GPT-4.

Chaque année, Gurari organise un atelier appelé Viz Wiz lors de la conférence de la vision par ordinateur et de la reconnaissance des modèles pour amener des entreprises comme Envision avec des chercheurs en IA et des utilisateurs de technologies aveugles. Quand Wiz Water Lancé en 2018, seules quatre équipes ont participé à l'atelier. Cette année, plus de 50 équipes se sont inscrites.

Dans les tests précoces de certains modèles d'image à texte, Gurari a constaté qu'ils peuvent créer des informations, ou «hallucine». «La plupart de ce à quoi vous pouvez faire confiance n'est que les objets de haut niveau, comme« Je vois une voiture, je vois une personne, je vois un arbre », dit-elle. Ce ne sont pas des informations triviales, mais un utilisateur ne peut pas nécessairement croire que l'IA lui dira correctement ce qu'il y a dans son sandwich.

«Lorsque les aveugles obtiennent ces informations, nous savons des interviews antérieures qu'ils préfèrent quelque chose plutôt que rien, donc c'est fantastique. Le problème est lorsqu'ils prennent des décisions sur des informations fausses, qui peuvent laisser un mauvais goût dans leur bouche », dit-elle.

Si une IA se trompe par une description en identifiant les médicaments mal identifiés, par exemple, cela pourrait avoir des conséquences potentiellement mortelles.

L'utilisation de modèles de grandes langues prometteurs mais imparfaits pour aider les aveugles à «voir» le monde peut également les laisser exposés à la tendance de l'IA à identifier mal l'âge, la race et le sexe des gens. Les ensembles de données qui ont été utilisés pour former l'IA sont connus pour être biaisés et biaisés, codant pour les préjugés et les erreurs. Les systèmes de vision informatique pour la détection d'objets ont une histoire de biais occidentaux, et la reconnaissance du visage a eu sorties moins précises Pour des groupes comme Asie, personnes transgenreset Femmes à la peau foncée.

Bahram reconnaît que ce sont des risques et suggère que les systèmes offrent aux utilisateurs un score de confiance afin qu'ils puissent prendre des décisions plus éclairées sur ce que l'IA pense que cela voit. Mais il dit que les aveugles ont droit à la même information que les personnes voyantes. «C'est un mauvais service de prétendre que chaque personne vue ne remarque pas immédiatement [attributes like gender or skin tone]qu'ils agissent ou non là-dessus », dit-il. «Alors pourquoi est [withholding] C'est juste pour quelqu'un qui n'a pas accès à des informations visuelles? “

La technologie ne peut pas conférer les compétences de mobilité de base dont une personne aveugle a besoin pour l'indépendance, mais les testeurs bêta d'Envision sont impressionnés par le système jusqu'à présent. Il a des limites, bien sûr. Robles, qui joue de la trompette, aimerait pouvoir lire la musique, et pour que le système fournisse un contexte plus spatial – où une personne ou un objet est dans une pièce et comment ils sont orientés – ainsi que plus de détails.

“Ce serait vraiment cool de savoir:” Hé, qu'est-ce que cette personne porte? “”, Dit-elle. «Cela pourrait se tromper. L'IA n'est pas parfaite en aucun cas, mais je pense que chaque petit morceau aide en ce qui concerne la description. »