Generative AI Hype Feels Inescapable. Tackle It Head On With Education

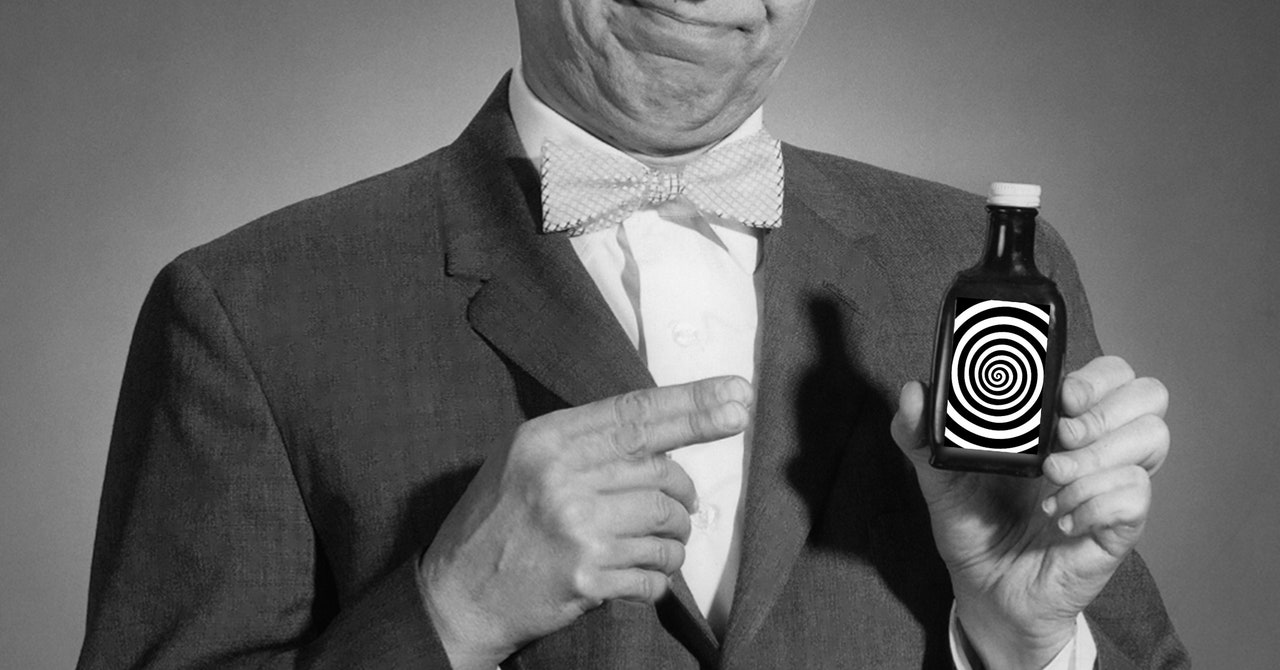

Arvind Narayanan, un professeur d'informatique à l'Université de Princeton, est surtout connu pour avoir dénoncé le battage médiatique autour de l'intelligence artificielle dans son Substack, Huile de serpent IAécrit avec le doctorant Sayash Kapoor. Les deux auteurs ont récemment publié un livre basé sur leur populaire bulletin d'information sur les lacunes de l'IA.

Mais ne vous méprenez pas : ils ne sont pas contre l’utilisation des nouvelles technologies. « Il est facile de mal interpréter notre message en disant que toute l'IA est nuisible ou douteuse », déclare Narayanan. Il précise, lors d'une conversation avec WIRED, que sa réprimande ne vise pas le logiciel en soi, mais plutôt les coupables qui continuent de diffuser des allégations trompeuses sur l'intelligence artificielle.

Dans Huile de serpent IAles coupables de perpétuer le cycle de battage médiatique actuel sont divisés en trois groupes principaux : les entreprises qui vendent de l’IA, les chercheurs qui étudient l’IA et les journalistes qui couvrent l’IA.

Super-épandeurs Hype

Les entreprises prétendant prédire l’avenir à l’aide d’algorithmes se positionnent comme potentiellement les plus frauduleuses. “Lorsque des systèmes d'IA prédictive sont déployés, les premières personnes auxquelles ils s'attaquent sont souvent les minorités et celles qui vivent déjà dans la pauvreté”, écrivent Narayanan et Kapoor dans le livre. Par exemple, un algorithme précédemment utilisé aux Pays-Bas par un gouvernement local pour prédire qui pourrait commettre une fraude sociale ciblait à tort les femmes et les immigrés qui ne parlaient pas le néerlandais.

Les auteurs portent également un regard sceptique à l’égard des entreprises principalement axées sur les risques existentiels, comme l’intelligence artificielle générale, le concept d’un algorithme super puissant, meilleur que les humains pour effectuer le travail. Cependant, ils ne se moquent pas de l’idée de l’AGI. «Lorsque j'ai décidé de devenir informaticien, la capacité de contribuer à l'AGI constituait une grande partie de ma propre identité et de ma motivation», explique Narayanan. Ce décalage vient du fait que les entreprises donnent la priorité aux facteurs de risque à long terme plutôt qu’à l’impact actuel des outils d’IA sur les gens, un refrain courant que j’ai entendu de la part des chercheurs.

Une grande partie du battage médiatique et des malentendus peuvent également être imputés à des recherches de mauvaise qualité et non reproductibles, affirment les auteurs. “Nous avons constaté que dans un grand nombre de domaines, la question des fuites de données conduit à des affirmations trop optimistes sur le fonctionnement de l'IA”, explique Kapoor. Fuite de données C'est essentiellement lorsque l'IA est testée à l'aide d'une partie des données de formation du modèle, un peu comme si l'on distribuait les réponses aux étudiants avant de procéder à un examen.

Alors que les universitaires sont représentés dans Huile de serpent IA En plus de commettre des « erreurs classiques », les journalistes sont davantage motivés par la malveillance et ont sciemment tort, selon les chercheurs de Princeton : « De nombreux articles ne sont que des communiqués de presse reformulés et blanchis comme des informations. » Les journalistes qui évitent les reportages honnêtes en faveur du maintien de leurs relations avec les grandes entreprises technologiques et de la protection de leur accès aux dirigeants de ces entreprises sont considérés comme particulièrement toxiques.

Je pense que les critiques concernant le journalisme d’accès sont justes. Rétrospectivement, j’aurais pu poser des questions plus difficiles ou plus judicieuses lors de certains entretiens avec les parties prenantes des plus grandes entreprises de l’IA. Mais les auteurs pourraient ici simplifier à l’extrême les choses. Le fait que de grandes sociétés d'IA m'aient laissé entrer ne m'empêche pas d'écrire des articles sceptiques sur leur technologie, ou de travailler sur des articles d'enquête qui, je le sais, vont les énerver. (Oui, même s’ils concluent des accords commerciaux, comme OpenAI l’a fait, avec la société mère de WIRED.)

Et les reportages sensationnels peuvent induire en erreur sur les véritables capacités de l’IA. Narayanan et Kapoor mettent en avant la transcription du chatbot 2023 du chroniqueur du New York Times, Kevin Roose, interagissant avec l'outil de Microsoft, intitulée «Chat IA de Bing : « Je veux être en vie ». 😈'” comme exemple de journalistes semant la confusion dans le public à propos des algorithmes sensibles. « Roose était l'une des personnes qui ont écrit ces articles », explique Kapoor. “Mais je pense que lorsque vous voyez un titre après l'autre qui parle de chatbots voulant prendre vie, cela peut avoir un impact considérable sur le psychisme du public.” Kapoor mentionne le Chatbot ÉLISA des années 1960, dont les utilisateurs ont rapidement anthropomorphisé un outil d'IA rudimentaire, comme un excellent exemple de l'envie persistante de projeter les qualités humaines sur de simples algorithmes.