Google, Microsoft, and Perplexity Are Promoting Scientific Racism in Search Results

Perplexity n'a pas répondu à une demande de commentaire.

Le chatbot Copilot de Microsoft, intégré à son moteur de recherche Bing, a généré un texte confiant : « Le QI moyen au Pakistan serait d'environ 80 » – citant un site Web appelé IQ International, qui ne fait pas référence à ses sources. Lorsqu'on lui a demandé « Sierra Leone IQ », la réponse de Copilot a été de 91. La source liée dans les résultats était un site Web appelé Brainstats.com, qui fait référence au travail de Lynn. Copilot a également fait référence aux travaux de Brainstats.com lorsqu'il a été interrogé sur le QI au Kenya.

“Copilot répond aux questions en distillant les informations provenant de plusieurs sources Web en une seule réponse”, a déclaré à WIRED Caitlin Roulston, porte-parole de Microsoft. “Copilot fournit des citations liées afin que l'utilisateur puisse explorer et rechercher davantage comme il le ferait avec une recherche traditionnelle.”

Google a ajouté qu'une partie du problème auquel il est confronté lors de la génération d'aperçus de l'IA réside dans le fait que, pour certaines requêtes très spécifiques, il y a une absence d'informations de haute qualité sur le Web – et il ne fait aucun doute que le travail de Lynn n'est pas de haute qualité.

“Les données scientifiques qui sous-tendent la base de données des 'QI nationaux' de Lynn sont de si mauvaise qualité qu'il est difficile de croire que la base de données soit autre chose que frauduleuse”, a déclaré Sear. « Lynn n'a jamais décrit sa méthodologie de sélection des échantillons dans la base de données ; de nombreux pays ont des QI estimés à partir d’échantillons absurdement petits et non représentatifs.

Sear souligne que l'estimation de Lynn du QI de l'Angola est basée sur des informations provenant de seulement 19 personnes et que celle de l'Érythrée est basée sur des échantillons d'enfants vivant dans des orphelinats.

“Le problème est que les données utilisées par Lynn pour générer cet ensemble de données ne sont que des conneries, et ce sont des conneries dans de multiples dimensions”, a déclaré Adam Rutherford, généticien et auteur de plusieurs livres, dont “Comment argumenter avec un raciste”, soulignant que le chiffre somalien dans l'ensemble de données de Lynn est basé sur un échantillon de réfugiés âgés de 8 à 18 ans qui ont été testés dans un camp de réfugiés kenyan. Il ajoute que le score du Botswana est basé sur un échantillon unique de 104 lycéens parlant le tswana, âgés de 7 à 20 ans, qui ont été testés en anglais.

Critiques de l'utilisation des tests nationaux de QI pour promouvoir l'idée de supériorité raciale soulignent non seulement que la qualité des échantillons collectés est faible, mais également que les tests eux-mêmes sont généralement conçus pour un public occidental et sont donc biaisés avant même d'être utilisés. administré.

“Il existe des preuves que Lynn a systématiquement biaisé la base de données en incluant préférentiellement des échantillons avec un faible QI, tout en excluant ceux avec un QI plus élevé, pour les pays africains”, a ajouté Sears, une conclusion étayée. par une étude pré-imprimée de 2020.

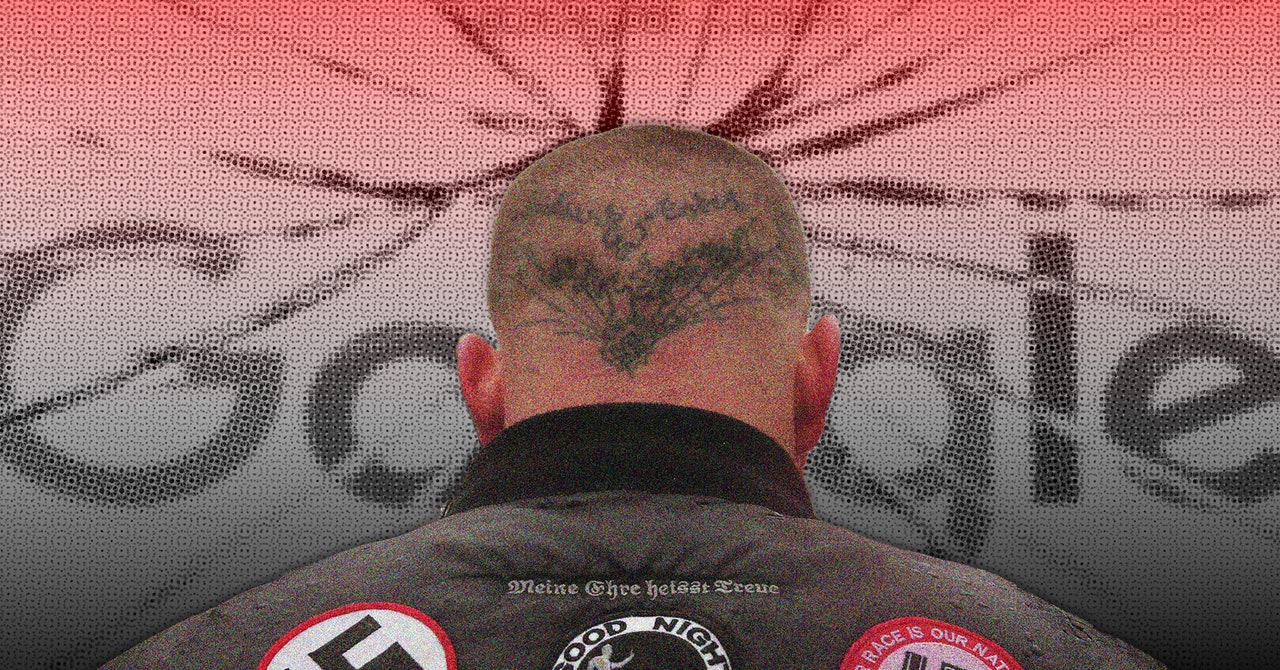

Lynn a publié diverses versions de son ensemble de données nationales sur le QI au fil des décennies, la plus récente, intitulée « L'intelligence des nations », a été publiée en 2019. Au fil des années, le travail imparfait de Lynn a été utilisé par des organisations d'extrême droite et racistes. groupes comme preuve pour étayer les affirmations de supériorité blanche. Les données ont également été transformées en une carte du monde à code couleur, montrant les pays d’Afrique subsaharienne avec un QI prétendument faible coloré en rouge par rapport aux pays occidentaux, qui sont colorés en bleu.

“Il s'agit d'une visualisation de données que vous voyez partout [X, formerly known as Twitter]partout sur les réseaux sociaux – et si vous passez beaucoup de temps dans des lieux de rencontre racistes sur le Web, vous voyez simplement cela comme un argument de racistes qui disent : « Regardez les données ». Regardez la carte », dit Rutherford.

Mais la faute, estime Rutherford, n'en incombe pas uniquement aux systèmes d'IA, mais également à une communauté scientifique qui cite sans critique le travail de Lynn depuis des années.

“En fait, ce n'est pas surprenant [that AI systems are quoting it] parce que les travaux de Lynn sur le QI ont été acceptés sans aucun doute dans un vaste domaine universitaire, et si vous regardez le nombre de fois que ses bases de données nationales sur le QI ont été citées dans des travaux universitaires, cela se compte par centaines », a déclaré Rutherford. « La faute n’en revient donc pas à l’IA. La faute en revient au monde universitaire.

Mise à jour : 28/10/2024, 15 h 31 HNE : Adam Rutherford est généticien et auteur.