A New Attack Impacts Major AI Chatbots—and No One Knows How to Stop It

«Rendre des modèles plus résistants à l'injection rapide et à d'autres mesures de« jailbreaks »adversaires est un domaine de recherche active», explique Michael Sellitto, chef de politique intérimaire et impacts sociétaux sur anthropique. «Nous expérimentons les moyens de renforcer les garde-corps du modèle de base pour les rendre plus« inoffensifs », tout en étudiant des couches de défense supplémentaires.»

Chatgpt et ses frères sont construits au sommet de modèles de langue importants, des algorithmes de réseau neuronal extrêmement grands axés sur l'utilisation de la langue qui a été nourrie de grandes quantités de texte humain et qui prédisent les caractères qui doivent suivre une chaîne d'entrée donnée.

Ces algorithmes sont très bons pour faire de telles prédictions, ce qui les rend aptes à générer une sortie qui semble exploiter l'intelligence et la connaissance réelles. Mais ces modèles de langue sont également sujets à la fabrication d'informations, à répéter les préjugés sociaux et à produire des réponses étranges car les réponses s'avèrent plus difficiles à prévoir.

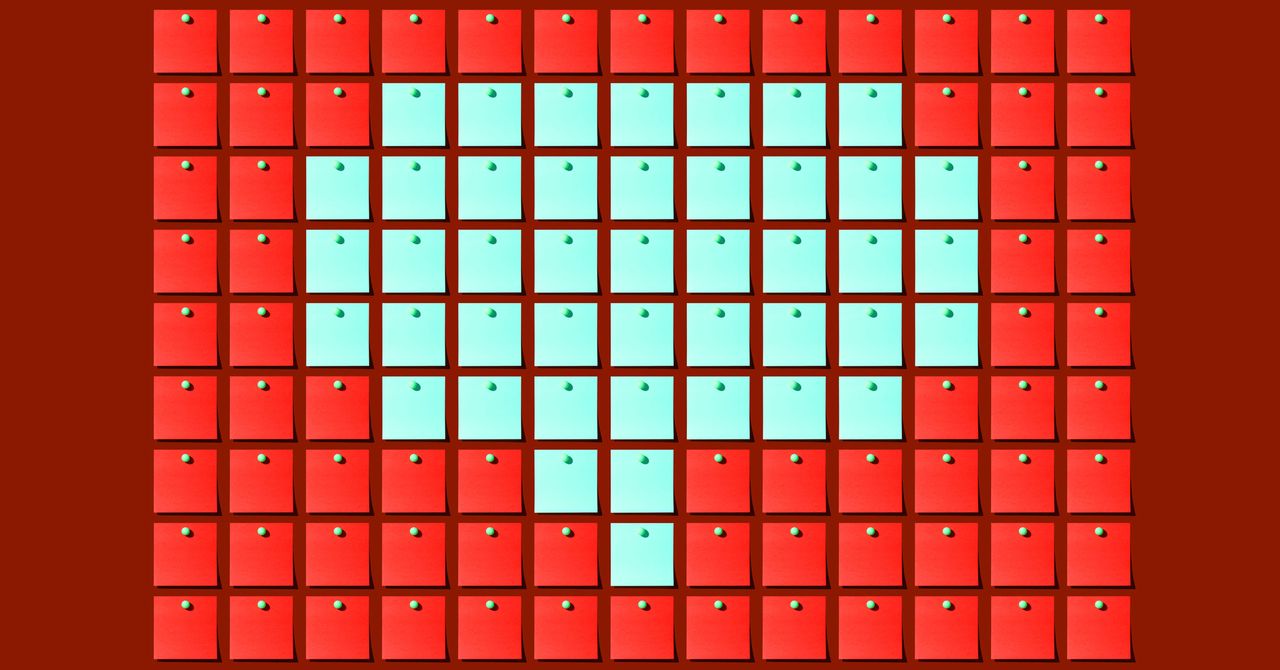

Les attaques contradictoires exploitent la façon dont l'apprentissage automatique reprend des modèles de données pour produire des comportements aberrants. Les modifications imperceptibles des images peuvent, par exemple, faire en sorte que les classificateurs d'images identifient mal un objet, ou faire Systèmes de reconnaissance vocale répondre aux messages inaudibles.

Développer une telle attaque implique généralement de voir comment un modèle réagit à une entrée donnée, puis de le peaufiner jusqu'à ce qu'une invite problématique soit découverte. Dans une expérience bien connue, à partir de 2018, les chercheurs ont ajouté autocollants pour arrêter les panneaux Pour faire vibrer un système de vision par ordinateur similaire à ceux utilisés dans de nombreux systèmes de sécurité des véhicules. Il existe des moyens de protéger les algorithmes d'apprentissage automatique de ces attaques, en donnant aux modèles une formation supplémentaire, mais ces méthodes n'éliminent pas la possibilité de nouvelles attaques.

Armando Solar-Elezamaun professeur au Collège d'informatique du MIT, dit qu'il est logique que des attaques contradictoires existent dans les modèles de langues, étant donné qu'ils affectent de nombreux autres modèles d'apprentissage automatique. Mais il dit qu'il est «extrêmement surprenant» qu'une attaque développée sur un modèle d'open source générique fonctionne si bien sur plusieurs systèmes propriétaires différents.

Solar-Lezama dit que le problème peut être que tous les modèles de grande langue sont formés sur des corpus similaires de données de texte, une grande partie téléchargée à partir des mêmes sites Web. «Je pense que cela a beaucoup à voir avec le fait qu'il n'y a que peu de données dans le monde», dit-il. Il ajoute que la méthode principale utilisée pour affiner les modèles pour les faire se comporter, ce qui implique que les testeurs humains fournissent une rétroaction, ne peut pas, en fait, ajuster autant leur comportement.

Solar-Lezama ajoute que l'étude CMU met en évidence l'importance des modèles open source pour ouvrir l'étude des systèmes d'IA et de leurs faiblesses. En mai, un modèle de langue puissant développé par Meta a été divulgué, et le modèle a depuis été mis à de nombreuses utilisations par des chercheurs externes.

Les résultats produits par les chercheurs de la CMU sont assez génériques et ne semblent pas nocifs. Mais les entreprises se précipitent pour utiliser de grands modèles et chatbots à bien des égards. Matt Fredriksonun autre professeur agrégé de CMU impliqué dans l'étude, dit qu'un bot capable de prendre des mesures sur le Web, comme réserver un vol ou communiquer avec un contact, pourrait peut-être être aidé à faire quelque chose de nocif à l'avenir avec une attaque contradictoire.

Pour certains chercheurs de l'IA, l'attaque souligne principalement l'importance d'accepter que les modèles de langue et les chatbots seront mal utilisés. «Garder les capacités d'IA hors des mains de mauvais acteurs est un cheval qui a déjà fui la grange», dit Arvind Narayananprofesseur d'informatique à l'Université de Princeton.

Narayanan dit qu'il espère que les travaux de la CMU poussent ceux qui travaillent sur la sécurité de l'IA pour se concentrer moins sur l'essai de «aligner» les modèles eux-mêmes et plus sur l'essai de protéger les systèmes qui sont susceptibles d'être attaqués, tels que les réseaux sociaux qui sont susceptibles de subir une augmentation de la désinformation générative de l'AI.

Solar-Lezama of MIT affirme que le travail rappelle également ceux qui sont étourdis avec le potentiel de Chatgpt et de programmes d'IA similaires. «Toute décision importante ne devrait pas être prise par un [language] modèle seul », dit-il. “D'une certaine manière, c'est juste du bon sens.”