Nvidia Chip Shortages Leave AI Startups Scrambling for Computing Power

Fournisseurs de cloud computing sont très conscients que leurs clients sont aux prises avec la capacité. La demande de la demande a «pris un peu l'industrie au dépourvu», explique Chetan Kapoor, directeur de la gestion des produits chez AWS.

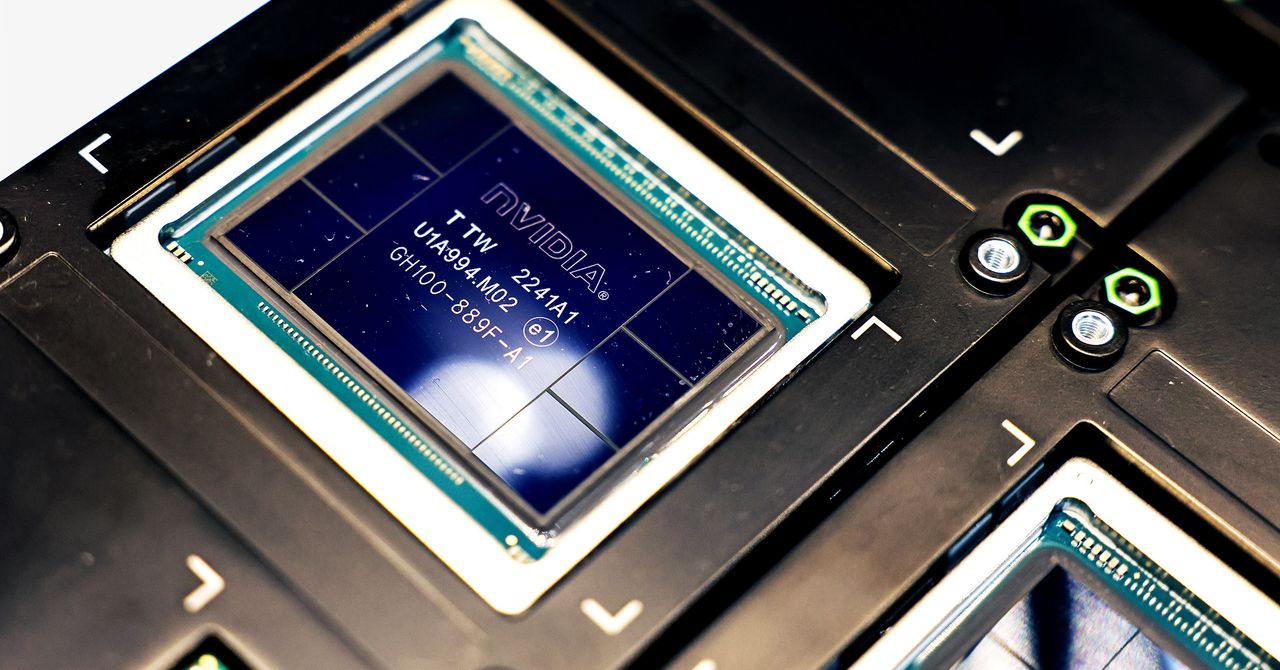

Le temps nécessaire pour acquérir et installer de nouveaux GPU dans leurs centres de données a mis les géants du cloud derrière, et les dispositions spécifiques de la plus forte demande ajoutent également du stress. Alors que la plupart des applications peuvent fonctionner à partir de processeurs de manière lâche réparti dans le monde, la formation des programmes d'IA génératifs a eu tendance à fonctionner le mieux lorsque les GPU sont physiquement regroupés ensemble, parfois 10 000 puces à la fois. Cela relie la disponibilité comme jamais auparavant.

Kapoor dit que le client génératif de l'IA typique d'AWS accède à des centaines de GPU. “S'il y a une demande à un client en particulier qui a besoin de 1 000 GPU demain, cela va prendre un peu de temps pour que nous les gardiez”, explique Kapoor. “Mais s'ils sont flexibles, nous pouvons le résoudre.”

AWS a suggéré que les clients adoptent des services plus chers et personnalisés grâce à son offre de substratum rocheux, où les besoins en puce sont cuits dans l'offre sans que les clients ne se soucient pas. Ou les clients pourraient essayer les puces d'IA uniques d'AWS, Trainium et Inferentia, qui ont enregistré une augmentation non spécifiée de l'adoption, explique Kapoor. La modernisation des programmes pour fonctionner sur ces puces au lieu des options Nvidia a traditionnellement été une corvée, bien que Kapoor dit que le passage à Trainium ne prend désormais pas aussi peu que de modifier deux lignes de code logiciel dans certains cas.

Les défis abondent ailleurs aussi. Google Cloud n'a pas été en mesure de répondre à la demande de son équivalent de GPU local, connu sous le nom de TPU, selon un employé non autorisé à parler aux médias. Un porte-parole n'a pas répondu à une demande de commentaires. L'unité Cloud Azure de Microsoft a suspendu les remboursements aux clients qui n'utilisent pas les GPU qu'ils ont réservés, les informations rapporté en avril. Microsoft a refusé de commenter.

Les entreprises cloud préféreraient que les clients se réservent des mois à des années afin que ces fournisseurs puissent mieux planifier leurs propres achats et installations GPU. Mais les startups, qui ont généralement un minimum d'argent et des besoins intermittentes lorsqu'ils trient leurs produits, ont hésité à s'engager, préférant les plans d'achat à votre avance. Cela a conduit à une augmentation des affaires pour des fournisseurs de cloud alternatifs, tels que Lambda Labs et Corequi a tiré près de 500 millions de dollars des investisseurs cette année entre eux. Astria, la startup du générateur d'images, fait partie de leurs clients.

AWS n'est pas vraiment content de perdre contre les nouveaux entrants du marché, il envisage donc des options supplémentaires. «Nous réfléchissons à différentes solutions à court et à long terme pour fournir l'expérience que nos clients recherchent», explique Kapoor, refusant de développer.

Les pénuries chez les vendeurs de cloud sont en cascade à leurs clients, qui incluent certains grands noms dans la technologie. Plateforme de médias sociaux Pinterest élargit son utilisation de l'IA pour mieux servir les utilisateurs et les annonceurs, selon le directeur de la technologie Jeremy King. La société envisage d'utiliser les nouvelles puces d'Amazon. «Nous avons besoin de plus de GPU, comme tout le monde», explique King. “La pénurie de puces est une chose réelle.”